Data Factory

Durch eine sogenannte Data Factory werden große Mengen notwendiger Daten systematisch für die verschiedenen Anwendungsfälle des digitalisierten Bahnsystems erzeugt, aufbereitet und zur Verfügung gestellt. Ein prominenter Anwendungsfall ist dabei das Trainieren von Systemen, die mit Künstlicher Intelligenz (KI) arbeiten wie beispielsweise die Umfeld- und Hinderniserkennung. Die Datenbasis besteht dabei zum einen aus der Aufzeichnung von realen Sensordaten des Gleisumfelds und zum anderen aus simulierten, künstlich generierten Bildern.

Projektlaufzeit

Unsere Partner

Die Digitale Schiene Deutschland hat 2022 mit dem Aufbau einer „Data Factory“ begonnen. Dort wird es zukünftig möglich sein, große Mengen notwendiger Daten für die verschiedenen Anwendungsfälle des digitalisierten Bahnsystems systematisch zu erzeugen, zu sammeln und gezielt bereitzustellen. Einerseits erzeugen digitale Systeme große Mengen an Daten, so z. B. Sensoren und Kameras an Zügen, die das Gleisumfeld detailliert beobachten. Andererseits erfordert Digitalisierung auch eine systematische Erzeugung von Daten, um z. B. Künstliche Intelligenz (KI), ausreichend „trainieren“ zu können. Ein populärer Anwendungsfall ist dabei das „Training“ von KI-Software für sensorbasierte Wahrnehmungssysteme. Dies wird insbesondere im Kontext des vollautomatisierten, fahrerlosen Fahrens (sog. Grade of Automation 4, GoA4) benötigt. Um eine solche KI-Software z. B. für die Umfeldwahrnehmung zu entwickeln, werden große Mengen an realen Sensordaten und simulierten Daten mit sehr hoher Datenqualität benötigt.

Solche Daten für das Training KI-basierter Funktionen über eine einheitliche Cloud- und IT-Plattform zu organisieren, ist eine große Herausforderung. Die Plattform soll die Aufbereitung und Nutzung dieser Daten durch verschiedene Akteur:innen (Betreiber, Hersteller, KI-Expert:innen etc.) ermöglichen.

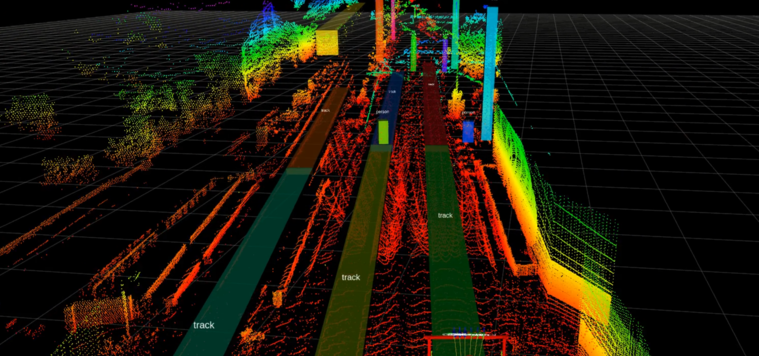

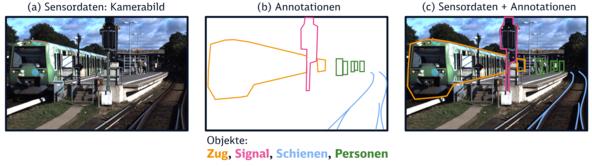

Die erforderlichen Datenmengen können zum einen durch die Aufzeichnung von realen Sensordaten im Gleisumfeld und zum anderen durch die Generierung von künstlichen Daten mit verschiedenen Simulationsumgebungen erzeugt werden. Die aufgenommenen Realdaten müssen im Nachgang bearbeitet und die Bildbereiche mit den zu erlernenden Objekten vorher markiert werden. Diese markierten Bildbereiche nennt man Annotationen.

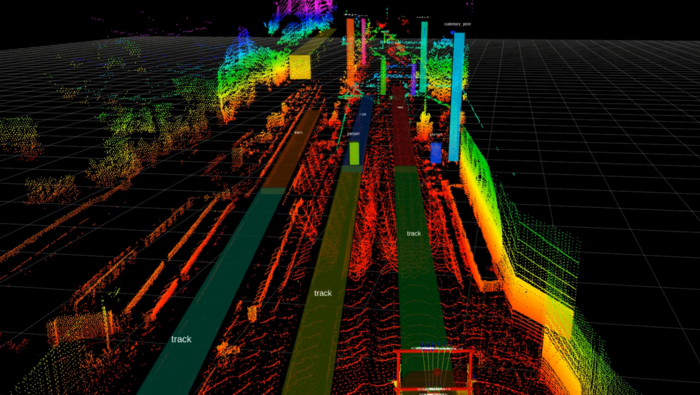

Bei der Simulation von künstlichen Sensordaten werden Daten „hergestellt“– vergleichbar mit den simulierten 3D-Umgebungen von Computerspielen. Diese zusätzliche Simulation ist notwendig, weil es unmöglich ist, durch Aufzeichnungen des regulären Bahnbetriebs alle denkbaren Ereignisse und Sonderfälle des Bahnbetriebs zu erfassen. Außerdem stellt die Simulation von Daten eine signifikante Kosteneinsparung im Vergleich zu real erfassten Daten dar.

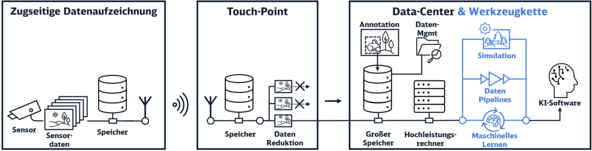

Um die Datenbasis zum Training von KI-Software darüber hinaus stetig zu verbessern, ist ein sogenannter „Data-Loop“ erforderlich. Dies ist ein Datenkreislauf, bestehend aus Realdaten und simulierten Daten. Um die immense Datenmenge und den Data-Loop für das kontinuierliche Training der KI bereitzustellen, sind drei Schritte notwendig:

- Die von der Sensorik am Zug detektieren Daten werden während der Zugfahrt aufgezeichnet.

- Touch-Points, die sich drahtlos mit einem Zug in Reichweite verbinden, laden die große Menge der gesammelten Sensordaten herunter. Die Daten werden dort vorverarbeitet und vorsortiert (Datenreduktion).

- Der relevante Anteil der Realdaten wird dann an das Data-Center übermittelt. Die Realdaten werden verwaltet, visualisiert und durchsuchbar gemacht und mit den simulierten Daten zusammengebracht.

Durch eine softwarebasierte Werkzeugkette gelangen die simulierten Daten ebenfalls in das Data Center. Für diese Aufgabe braucht es eine hochleistungsfähige State-of the-Art Infrastruktur mit Hochleistungsprozessoren, enormer Speicherkapazität und Cloudanbindung.

- Training von KI-Software für Umfeldwahrnehmung und Hinderniserkennung bei Zugfahrten

- Ermöglichung der Nutzung sensorbasierter Wahrnehmungssysteme für die fahrzeugseitige Streckenbeobachtung durch den Zug

- Grundlage für die Realisierung von vollautomatisiertem Fahren

- Cloudanbindung für Verwirklichung einer europäisch vernetzten Data Factory

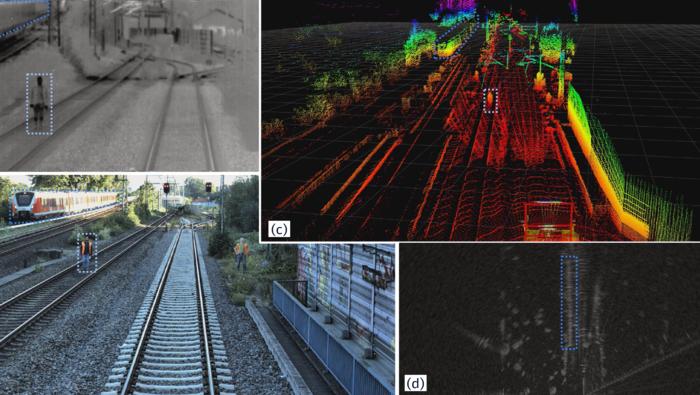

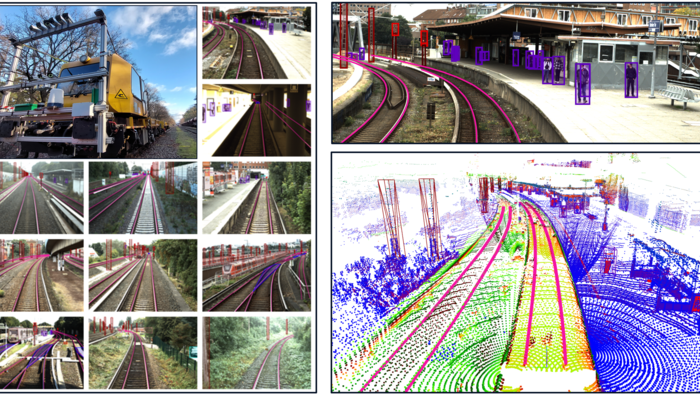

Bisher gibt es kaum öffentliche Datensätze aus dem Bahnbereich. Deshalb hat die DB InfraGo AG im Rahmen der Sektorinitiative „Digitale Schiene Deutschland“ zusammen mit dem Deutschen Zentrum für Schienenverkehrsforschung (DZSF) beim Eisenbahn-Bundesamt (EBA) den ersten öffentlich verfügbaren Multisensordatensatz OSDaR23 erstellt und veröffentlicht.

Der Datensatz besteht aus zeitsynchronisierten Sensordaten von:

- 3 hochauflösende Kameras, 3 mittelauflösende Kameras, 3 Infrarotkameras

- 3 Langstrecken-LiDARe, 1 Mittelbereichs-Lidar, 2 Kurzstrecken-LiDARe

- 1 Langstreckenradar, 4 Inertiale Messeinheiten, 4 GPS/GNSS-Sensoren

Der Datensatz beinhaltet Annotationen von 20 Objektklassen, besitzt das Annotationsformat

ASAM Open Label und kann unter https://data.fidmove.de/dataset/osdar23 heruntergeladen werden.

Weitere Informationen:

https://digitale-schiene-deutschland.de/Downloads/ETR-OSDaR23.pdf

https://digitale-schiene-deutschland.de/aktuelles/Data-Factory

Die Auswertung der Sensordaten beim vollautomatisierten Fahren geschieht voraussichtlich auch durch KI-Modelle, die mit Algorithmen des Maschinellen Lernens (ML) auf Basis von geeigneten Trainings-, Validierungs- und Testdaten entwickelt wurden. Grundlage für ML sind Datensätze aus Ein- und Ausgabedaten, anhand derer ein ML-Algorithmus „lernen“ kann. Bei der Objekterkennung bei ATO sind die Eingabedaten etwa Sensordaten, die die relevanten Bereiche, z.B. Fahrweg vor dem Zug erfassen. Außerdem müssen die zu erkennenden Objekte (z.B. Personen, Gleise) erfasst sein. Die Ausgabedaten umfassen alle Daten, die das zu entwickelnde ML-Modell aus den Eingabedaten ableiten soll. Das sind beispielsweise Ortskoordinaten der Bereiche, in denen sich zu erkennende Objekte befinden, Klassifizierungen der Objekte oder Ausprägungen von Objektattributen.

Aufgrund der großen Menge an Daten, die für das Entwickeln, Testen und Zulassen der ATO-Funktionen notwendig sein werden, erscheint eine zumindest teilautomatische Voranalyse sinnvoll. In den aufgezeichneten Daten können dann automatisiert bestimmte Objekte, Situationen oder Umgebungsbedingungen identifiziert werden. Gezielt bestimmte Daten zu finden, wird somit möglich - etwa aufgezeichnete Wildtiere oder Objekte, die in besonders relevanten Distanzen oder Zonen um das Gleis stehen. Diese lassen sich dann annotieren, um für das Training der KI-Verfahren nutzbar zu werden. Auch besondere Wetterbedingungen wie Regen oder Schneetreiben lassen sich automatisiert erkennen und als maschinell erzeugte Beschreibung zu den Daten hinzufügen. In Zukunft soll außerdem die Gesamteinschätzung der Situation, also wie relevant die Daten für ein KI-Training oder –Testen sind, mithilfe des Computers bewertet werden.

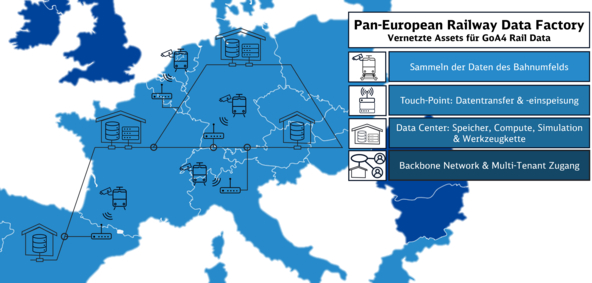

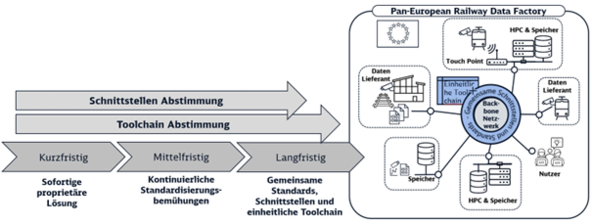

Der Aufbau und Betrieb einer Data Factory für ein vollständig digitalisiertes Bahnsystem ist eine große Aufgabe. Im Bahnsektor herrscht daher Konsens, dass einzelne Eisenbahnunternehmen oder Hersteller zukünftig nicht genügend Sensordaten bereitstellen können, um die zahlreichen KI-Funktionen ausreichend trainieren zu können. Im europäischen Bahnsektor gibt es daher Überlegungen, eine „pan-European Railway Data Factory“ mit einer gemeinsamen Infrastruktur zu schaffen, welche es Bahnunternehmen und Herstellern europaweit ermöglicht, Sensordaten zu sammeln, zu verarbeiten, zu simulieren und für die gegenseitige Nutzung zur Verfügung zu stellen.

Die Umsetzungsstrategie für die Pan-European Railway Data Factory (PEDF) ist in kurz-, mittel- und langfristige Maßnahmen unterteilt. Kurzfristig liegt der Fokus auf individuellen technischen und rechtlichen Lösungen für einzelne nationale Datenfabriken. Mittelfristig soll eine Angleichung der Standards erfolgen, um eine schrittweise Integration der Data Factories einzelner Mitglieder zu ermöglichen. Langfristig wird eine umfassende Koordinierung der Standardisierungsbemühungen angestrebt, insbesondere im Hinblick auf Datenqualität, -formate, Schnittstellen und Interkonnektivität.

Die Beteiligungspfade für PEDF-Mitglieder umfassen die Schnittstellen Abstimmungen für Flexibilität im Datenaustausch und die Toolchain Abstimmungen für die Harmonisierung von Werkzeugketten. Die Strategie zeichnet sich durch ihre pragmatische und schrittweise Entwicklung aus, um die PEDF zu einer vielseitigen und effektiven paneuropäischen Initiative zu machen.

Die Digitale Schiene Deutschland hat daher das Projekt „Rail Data Factory“ im Rahmen des Förderprogramms „CEF2 Digital“ mit ins Leben gerufen und gemeinsam mit der französischen Bahn SNCF und der niederländischen Bahn NS eine von der European Health and Digital Executive Agency (HADEA) co-finanzierte Studie durchgeführt. Gegenstand war die Bewertung der Umsetzbarkeit einer Pan-European Railway Data Factory aus technischer, wirtschaftlicher, regulatorischer und operativer Sicht. Die Studie startete im Januar 2023 und wurde im Dezember 2023 abgeschlossen. Durch ein so genanntes Rail Advisory Board und eine enge Synchronisation mit Data Factory-bezogenen Aktivitäten im Europe’s Rail Förderprojekt „R2DATO2 wird gewährleistet, dass die Studie die Bedarfe des Bahnsektors berücksichtigt und im Einklang vergleichbarer Aktivitäten durchgeführt wurde.

Neben der Ausarbeitung der Architektur und eines Umsetzungsplans war ein zentrales Ergebnis die Bestätigung, dass der Aufbau einer Pan-European Railway Data Factory für die Projektbeteiligten eine hohe Relevanz besitzt.

Weitere Informationen:

https://digitale-schiene-deutschland.de/de/aktuelles/Pan-European-Railway-Data-Factory

Projektlaufzeit Pan-European Railway Data Factory

Das Projekt ERJU „R2DATO“ (ERJU = Europe´s Rail Joint Undertaking) hat zum Ziel eine gemeinsame Innovationsroadmap der Bahnbetreiber und Hersteller für den künftigen europaweiten digitalen und automatisierten Bahnverkehr zu erarbeiten und die notwenigen technologischen Enabler hierfür zu entwickeln und zu erproben.

Im Rahmen des Arbeitspaketes 7 des „R2DATO“ Projekts, ist die Schaffung einer Umgebung für die Data Factory vorgesehen, welche eine kollaborative Daten- und Infrastrukturlösung bietet.

Einerseits werden Aspekte der Anforderungen an die Data Factory entwickelt und mit den Projektmitgliedern geteilt. Andererseits wird der Data Factory-Prototyp der Digitalen Schiene Deutschland parallel aufgebaut. Die Anforderungen konzentrieren sich auf die Assets im Data Center und die zukünftige Werkzeugkette sowie auf die Datenqualität und Annotation.

Die Werkzeugkette beinhaltet eine Datenplattform, welche die Datenverwaltung und -visualisierung übernimmt. Außerdem beinhaltet sie Tools zur Annotation von (Sensor-)Daten und eine Simulationsplattform, welche künstliche Daten synthetisiert (s. Abschnitt 2). Das Training und die Evaluation der KI-Funktionen wird in der Machine Learning Plattform durchgeführt, welche ebenfalls Bestandteil der Werkzeugkette ist. Die Testing & Certification Plattform soll die zukünftige Zulassung von KI-Funktionen unterstützen und eine Access & Information Plattform gewährleistet das nahtlose Zusammenspiel der einzelnen Werkzeuge.

Aufbauend auf den Ergebnissen der CEF2 Studie (Abschnitt 6), wird hier das Konzept der Pan-Europäischen Data Factory weiterverfolgt und ausgearbeitet. Ziel ist der Zusammenschluss von unabhängigen Data Factories und IT-Assets mittels eines Hochgeschwindigkeitsnetzwerks, die Definition gemeinsamer Schnittstellen sowie der Aufbau einer einheitlichen Toolchain.

Die einheitliche Toolchain soll dafür Sorge tragen, eine Datensouveränität zu gewährleisten sowie den diskriminierungsfreien Zugang der Stakeholder zu Daten zu ermöglichen. Darüber hinaus soll sie Synergien bei der Datenerhebung, Datenverarbeitung und der KI-Entwicklung schaffen und eine Zulassung von KI-Funktionen ermöglichen.

Ein Rechtsgutachten wird klären, welche Rechtsbereiche in dem Projekt R2DATO WP7 relevant sind. Dieses Gutachten wird somit die Grundlage für die weitere Ausarbeitung des Konzepts einer konsortial geführten Pan-Europäischen Data Factory darstellen.

Ein weiterer Bestandteil des Arbeitspakets ist die sektorweite Abstimmung bezüglich der Datensimulation und der Datenannotation. In Zusammenarbeit mit den Projektpartnern sollen im ersten Schritt nicht-reguläre Szenarien simuliert und Sensordaten annotiert werden.

Im nächsten Schritt werden diese Daten dann verwendet, um prototypische KI-Funktionen, insbesondere Objektdetektoren zu trainieren.

Die Digitale Karte (digital Register WP27) wird exemplarisch Kartendaten bereitstellen.

Abschließend wird ein Open-Data Set erstellt, welches reale Sensordaten, Annotationen, simulierte Sensordaten und Kartendaten enthält.

Projektlaufzeit

Unsere Partner

Fachartikel

-

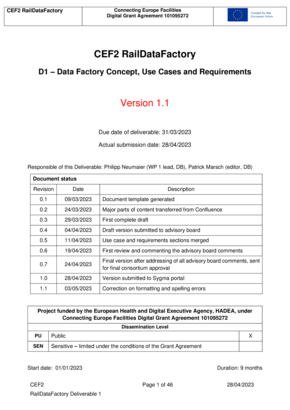

Studienergebnis "D1 – Data Factory Concept, Use Cases and Requirements" | Juni 2023

Die „pan-European Railway Data Factory“ ist eine Art Ökosystem mit einer gemeinsamen Infrastruktur, welches es Bahnunternehmen und Herstellern ermöglicht, Sensordaten europaweit zu sammeln, zu verarbeiten, zu simulieren und für die gegenseitige Nutzung zur Verfügung zu stellen.

*Die Studienergebnisse wurden nur auf Englisch publiziert

-

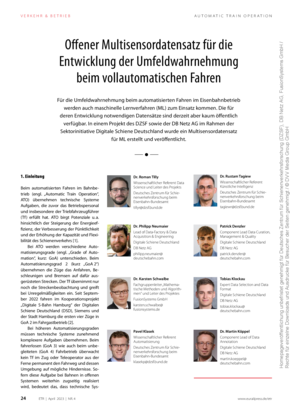

Artikel in "ETR - Eisenbahntechnische Rundschau" | Offener Multisensordatensatz für die Entwicklung der Umfeldwahrnehmung beim vollautomatischen Fahren | 04/23

Für die Umfeldwahrnehmung beim automatisierten Fahren im Eisenbahnbetrieb werden auch maschinelle Lernverfahren zum Einsatz kommen. Die für deren Entwicklung notwendigen Datensätze sind derzeit aber kaum öffentlich verfügbar. In einem Projekt des DZSF sowie der DB Netz AG im Rahmen der Sektorinitiative Digitale Schiene Deutschland wurde solch ein Multisensordatensatz erstellt und veröffentlicht.

Quelle: Eisenbahntechnische Rundschau